ChatGPT, Bard, Bing 등 인공지능 AI는 퀴즈나 수수께끼를 얼마나 잘 풀까 하는 호기심이 생겨서 바로 테스트를 해 봤습니다. 추론 능력이 있어야 하는 퀴즈 문제를 가지고 3개의 AI 챗봇의 문제 풀이 능력을 비교해 보겠습니다.

ChatGPT, Bard, Bing은 퀴즈를 얼마나 잘 풀까?

이번 글에서는 우리가 자주 접하는 퀴즈를 가지고 ChatGPT, Bard, Bing의 문제풀이 능력에 대해서 비교해 보았습니다. 긴 글의 요점을 정리하고 원하는 정보 제공에 있어서는 뛰어난 성능을 발휘하지만 사람과 같이 사고하고 추론하는 능력에는 한계가 있는 것 같다고 이전 글에서 언급을 했었는데 이번 테스트에서는 조금 다른 결과가 나왔습니다.

1. 챗봇에 물어볼 퀴즈

아래 퀴즈는 예전에 접해 보셨을 수도 있겠지만 사고 능력을 테스트하기에 좋을 것 같아 이 퀴즈를 가지고 테스트를 진행했습니다.

- 문제

8 - 6 = 2, 8 + 6 = 2 일 때, 7 + 6 은 얼마일까요?

- 정답

우선 이 퀴즈의 답부터 알아보겠습니다.

알고 나면 상당히 쉬운 문제인데요. 답은 바로 시계를 생각하시면 됩니다.

즉, 8시에서 6시간을 빼면 2시가 되고, 8시에 6시간을 더하면 2시가 됩니다. 답은 이런 식으로 7시에 6시간을 더하면 되고 1시, 즉 1이 답이 됩니다.

2. ChatGPT, Bard, Bing 테스트 결과

1) GPT 4.0

가장 기대가 컸던 것이 GPT4 였으나 답은 조금 실망스러웠습니다. 하지만 GPT4 스스로 수식간의 규칙성을 찾아내어 답을 하려고 한 것을 보면 조금 더 학습을 하면 정확한 답을 하지 않을까 하는 생각이 들었습니다.

2. GPT 3.5

GPT 3.5에게는 값을 구할 수 없다는 답변을 받았습니다. GPT 3.5가 확실히 사고적인 측면에서는 비교적 뒤처지는 것을 알 수 있습니다.

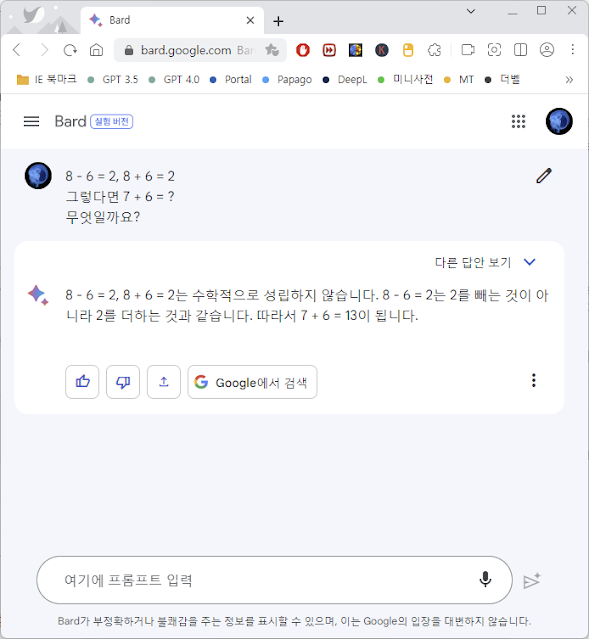

GPT3.5와 비슷한 답변을 했습니다. 아직까지는 추론하는 능력은 부족한 것으로 생각됩니다. Bard를 계속 써보면서 느끼는 것이지만 실시간으로 웹 데이터를 검색하는 것을 제외하고 성능향상을 위한 노력이 필요해 보입니다.

오늘은 위와 같이 인간과 같은 사고능력이 필요한 퀴즈 문제를 통해 GPT4, GPT3.5, Bard, Bing Chat의 결과를 비교해 보았습니다. 아직까지는 인간의 사고능력을 따라오지 못하고 있지만, GPT4는 조금 더 학습한다면 어느 정도 정답에 근접할 것으로 생각됩니다.

하지만 비교실험의 결과는 질문을 어떻게 하는지에 따라 결과가 많이 달라지기 때문에 질문을 효과적으로 하는 방법에 대해 평소에 공부해 놓는 것이 좋겠습니다.